中国科学技术大学潘建伟教授及其同事陆朝阳、刘乃乐等组成的研究团队在国际上首次实现量子机器学习算法。日前,国际权威物理学期刊《物理评论快报》发表了这一论文[Phys. Rev. Lett. 114, 110504 (2015)]。这是量子计算应用于大数据分析和人工智能领域的开创性实验工作。

机器学习是人工智能的核心,通过使机器模拟人类学习行为,智能化地从过去的经历中获得经验,从而改善其整体性能,重组内在知识结构,并对未知事件进行准确的推断。机器学习在科学和工程诸多领域都有着非常广泛的应用,例如金融分析、数据挖掘、生物信息学、医学诊断等。生活中常见的一些智能系统也广泛使用机器学习算法,例如电子商务、手写输入、邮件过滤等。

随着大数据时代的到来,人类产生的电子数据正在以每两年翻一番的增幅爆炸式增长。据估计,人类在过去三年间产生的数据总量超过了之前几千年产生的数据总量。另一方面,随着后摩尔时代的到来,经典计算机芯片尺寸难以进一步缩小,计算速度的进一步提升受到限制,科学家预测机器学习等大数据分析任务在未来或面临大数据爆炸式增长的巨大挑战。

应对这一挑战,欧美主要发达国家政府和高科技公司已经在积极整合研究力量和资源,抢滩布局,力争在量子信息技术应用方面占据先机。例如,2013年,美国国家航空航天局和Google联合成立了量子人工智能实验室。2014年,英国牛津大学、诺基亚公司、和全球最大军火供应商洛克希德马丁公司合建了量子优化和机器学习中心。

2013年,美国麻省理工学院(MIT)塞斯·罗伊德(Seth Lloyd)教授提出理论预言,利用量子系统在处理高维向量上的并行计算优势,可以为机器学习带来指数量级的加速,将能远远超越现有经典计算机的运算速度。理论估计,计算两个亿亿亿维向量的距离,用目前最快的、每秒钟亿亿次运算速度的经典计算机大概需要十年,而用GHz时钟频率的量子计算机则可需要不到1秒的时间。

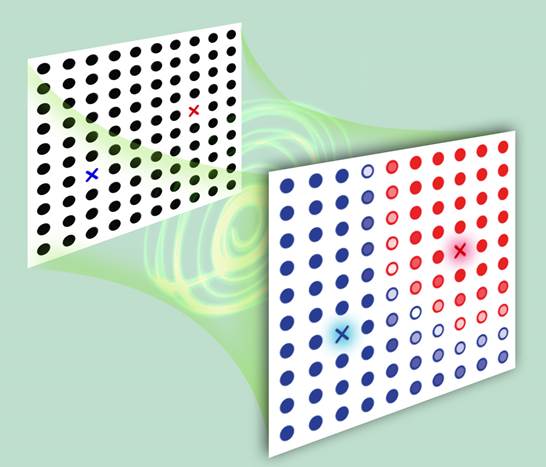

潘建伟小组发展了世界领先的光量子计算物理实现研究平台,在国际上率先实验实现了基于量子比特的机器学习算法演示。该算法的核心是通过以经典数据编码的微观量子态和辅助量子比特的纠缠,快速提取出不同向量间的内积、欧几里得距离等信息。审稿人一致评价该工作“非常前沿,具有高度的兴趣”、“在量子机器学习这个重要而有趣的课题迈出了第一步”。PhysOrg等国际科学新闻媒体报道了这一工作。

在中科院、教育部、科技部和基金委的长期支持下,潘建伟团队对光学量子计算开展了系统性和战略性的研究,取得了一系列开创性的成果:在世界上率先实现了五光子、六光子、八光子纠缠,制备了最高品质量子点单光子源,构建了基于多光子比特操纵的量子计算演示验证平台,开展了光子逻辑门、容失编码、拓扑量子纠错、多自由度隐形传态等面向可扩展量子计算的研究,首次实现了肖尔大数分解算法、任意子分数统计的量子模拟、求解线性方程组量子算法和量子人工智能算法等,在光学量子计算领域一直保持着国际领先地位。

论文链接:http://journals.aps.org/prl/abstract/10.1103/PhysRevLett.114.110504